O que é a pirataria informática?

A pirataria informática é a utilização da inteligência artificial para melhorar ou automatizar os ciberataques. Permite que os agentes de ameaças gerem código, analisem sistemas e escapem às defesas com o mínimo de esforço manual.

Os modelos de IA, especialmente os modelos de grande linguagem (LLM), tornam o desenvolvimento de ataques mais rápido, mais barato e mais acessível a hackers menos experientes. O resultado é um novo conjunto de ataques de IA que é mais rápido, mais escalável e, muitas vezes, mais difícil de travar com as defesas tradicionais.

O que é um hacker de IA?

Um hacker de IA é um agente de ameaça que utiliza a inteligência artificial para automatizar, melhorar ou escalar ciberataques. Os hackers de IA utilizam modelos de aprendizagem automática, IA generativa e agentes autónomos para contornar os controlos de segurança, criar ataques de phishing altamente convincentes e explorar vulnerabilidades de software à escala.

Estes atacantes podem incluir tanto operadores humanos que utilizam ferramentas de IA como sistemas semi-autónomos que executam tarefas com um mínimo de intervenção humana. Os atacantes humanos que utilizam a IA são indivíduos do mundo real - criminosos, "script kiddies", hacktivistas ou actores de estados-nação - que utilizam modelos de IA para aumentar as suas capacidades de ataque.

Os agentes de pirataria autónomos são fluxos de trabalho orientados por IA que podem encadear tarefas - como reconhecimento, geração de carga útil e evasão - com supervisão mínima. Embora continuem a ser guiados por objectivos definidos pelo homem, estes agentes podem funcionar de forma semi-independente uma vez lançados, executando ataques em várias etapas de forma mais eficiente do que as ferramentas manuais.

Como é que a IA é utilizada para a cibercriminalidade?

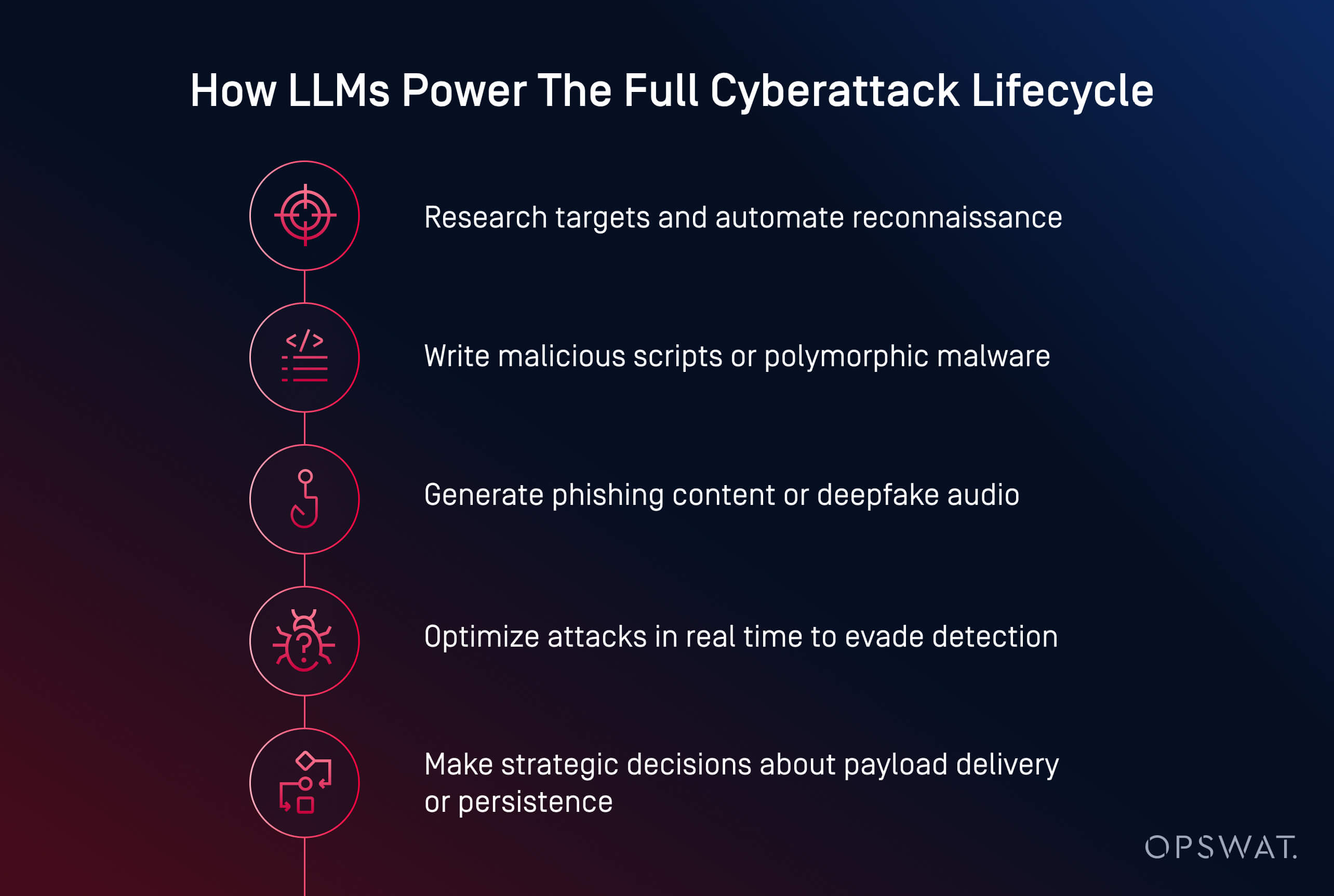

Os agentes de ameaças de IA utilizam agora a inteligência artificial para lançar ciberataques mais rápidos, mais inteligentes e mais adaptáveis. Desde a criação de malware até à automatização do phishing, a IA está a transformar a cibercriminalidade numa operação escalável. Atualmente, pode gerar código malicioso, escrever conteúdos de phishing persuasivos e até guiar os atacantes através de cadeias de ataque completas.

Os cibercriminosos utilizam a IA em várias áreas fundamentais:

- Geração de carga útil: Ferramentas como o HackerGPT e o WormGPT podem escrever malware ofuscado, automatizar tácticas de evasão e converter scripts em executáveis. Estes são exemplos de ataques de IA generativa, frequentemente observados em ciberataques de agentes de IA em que os modelos tomam decisões autónomas.

- Engenharia social: A IA cria mensagens electrónicas de phishing realistas, clona vozes e gera deepfakes para manipular as vítimas de forma mais eficaz.

- Reconhecimento e planeamento: A IA acelera a pesquisa de alvos, o mapeamento de infra-estruturas e a identificação de vulnerabilidades.

- Automatização à escala: Os atacantes utilizam a IA para lançar campanhas em várias fases com o mínimo de intervenção humana.

De acordo com o Instituto Ponemon, a IA já foi utilizada em campanhas de ransomware e ataques de phishing que causaram grandes perturbações operacionais, incluindo o roubo de credenciais e o encerramento forçado de mais de 300 locais de venda a retalho durante uma violação em 2023.

Vários padrões emergentes estão a remodelar o panorama das ameaças:

- Democratização dos ciberataques: Modelos de código aberto como o LLaMA, aperfeiçoados para o ataque, estão agora disponíveis para qualquer pessoa com capacidade de computação local

- Barreira de entrada mais baixa: O que antes exigia competências especializadas pode agora ser feito com simples instruções e alguns cliques

- Maior sucesso na evasão: O malware gerado por IA consegue esconder-se melhor da deteção estática, das caixas de areia e até da análise dinâmica

- Modelos de malware como serviço (MaaS): Os cibercriminosos estão a agrupar capacidades de IA em kits baseados em subscrições, facilitando o lançamento de ataques complexos em escala

- Utilização da IA em violações no mundo real: O Instituto Ponemon refere que os atacantes já utilizaram a IA para automatizar a seleção de alvos de ransomware, incluindo em incidentes que forçaram o encerramento de grandes operações

Phishing e engenharia social com base em IA

O phishing e a engenharia social com IA estão a transformar as fraudes tradicionais em ataques escaláveis e personalizados que são mais difíceis de detetar. Os agentes de ameaças utilizam agora modelos generativos para criar e-mails credíveis, clonar vozes e até produzir chamadas de vídeo falsas para manipular os seus alvos.

Ao contrário das fraudes tradicionais, os e-mails de phishing gerados por IA são polidos e convincentes. Ferramentas como o ChatGPT e o WormGPT produzem mensagens que imitam comunicações internas, contactos com o serviço de apoio ao cliente ou actualizações de RH. Quando emparelhados com dados violados, esses e-mails tornam-se personalizados e com maior probabilidade de sucesso.

A IA também potencia novas formas de engenharia social:

- Os ataques de clonagem de voz imitam os executivos utilizando amostras curtas de áudio para desencadear acções urgentes como transferências bancárias

- Ataques "deepfake " simulam videochamadas ou reuniões remotas para burlas de alto risco

Num incidente recente, os atacantes utilizaram e-mails gerados por IA durante um período de inscrição de benefícios, fazendo-se passar por RH para roubar credenciais e obter acesso aos registos dos funcionários. O perigo reside na ilusão de confiança. Quando uma mensagem de correio eletrónico parece ser interna, a voz soa familiar e o pedido parece urgente, até o pessoal com formação pode ser enganado.

Descoberta e exploração de vulnerabilidades de IA

A IA está a acelerar a forma como os atacantes encontram e exploram as vulnerabilidades do software. O que antes levava dias de sondagem manual pode agora ser feito em minutos utilizando modelos de aprendizagem automática treinados para reconhecimento e geração de exploits.

Os agentes de ameaças usam a IA para automatizar a verificação de vulnerabilidades em sistemas voltados para o público, identificando configurações fracas, software desatualizado ou CVEs não corrigidos. Ao contrário das ferramentas tradicionais, a IA pode avaliar o contexto de exposição para ajudar os atacantes a dar prioridade a alvos de elevado valor.

As tácticas comuns de exploração assistida por IA incluem:

- Fuzzing automatizado para descobrir vulnerabilidades de dia zero mais rapidamente

- Geração de scripts personalizados para execução remota de código ou movimento lateral

- Quebra de senhas e ataques de força bruta optimizados através da aprendizagem de padrões e modelos probabilísticos

- Bots de reconhecimento que analisam as redes em busca de activos de alto risco com o mínimo de ruído

Modelos generativos como o LLaMA, Mistral ou Gemma podem ser ajustados para gerar cargas úteis personalizadas, como shellcode ou ataques de injeção, com base em caraterísticas específicas do sistema, contornando frequentemente as salvaguardas incorporadas nos modelos comerciais.

A tendência é clara: a IA permite que os atacantes descubram e actuem sobre as vulnerabilidades à velocidade da máquina. De acordo com o Ponemon Institute, 54% dos profissionais de cibersegurança classificam as vulnerabilidades não corrigidas como a sua principal preocupação na era dos ataques com recurso à IA.

Malware e ransomware orientados para a IA

O aumento do malware gerado por IA significa que as defesas tradicionais já não são suficientes. Os atacantes têm agora ferramentas que pensam, se adaptam e fogem - muitas vezes mais depressa do que os defensores humanos conseguem responder.

O ransomware com IA e o malware polimórfico estão a redefinir a forma como os ciberataques evoluem. Em vez de escrever cargas úteis estáticas, os atacantes utilizam agora a IA para gerar malware polimórfico - código que muda constantemente para evitar a deteção.

As ameaças de ransomware também estão a evoluir. A IA pode ajudar a escolher os ficheiros a encriptar, analisar o valor do sistema e determinar o momento ideal para a detonação. Esses modelos também podem automatizar a delimitação geográfica, a evasão de sandbox e a execução na memória - técnicas normalmente usadas por agentes de ameaças avançadas.

A exfiltração de dados com IA adapta-se dinamicamente para evitar a deteção. Os algoritmos podem comprimir, encriptar e extrair dados de forma furtiva através da análise de padrões de tráfego, evitando os accionadores de deteção. Alguns agentes de malware estão a começar a tomar decisões estratégicas: escolhendo quando, onde e como exfiltrar com base no que observam dentro do ambiente comprometido.

Exemplos de ciberataques com IA

Os ciberataques com IA já não são teóricos; já foram utilizados para roubar dados, contornar as defesas e fazer-se passar por humanos em grande escala.

Os exemplos nas três categorias notáveis abaixo mostram que os atacantes já não precisam de competências avançadas para causar danos graves em ciberataques. A IA reduz a barreira à entrada, ao mesmo tempo que aumenta a velocidade, a escala e a discrição do ataque. Os defensores devem adaptar-se, testando proactivamente os sistemas integrados na IA e implementando salvaguardas que tenham em conta tanto a manipulação técnica como o engano humano.

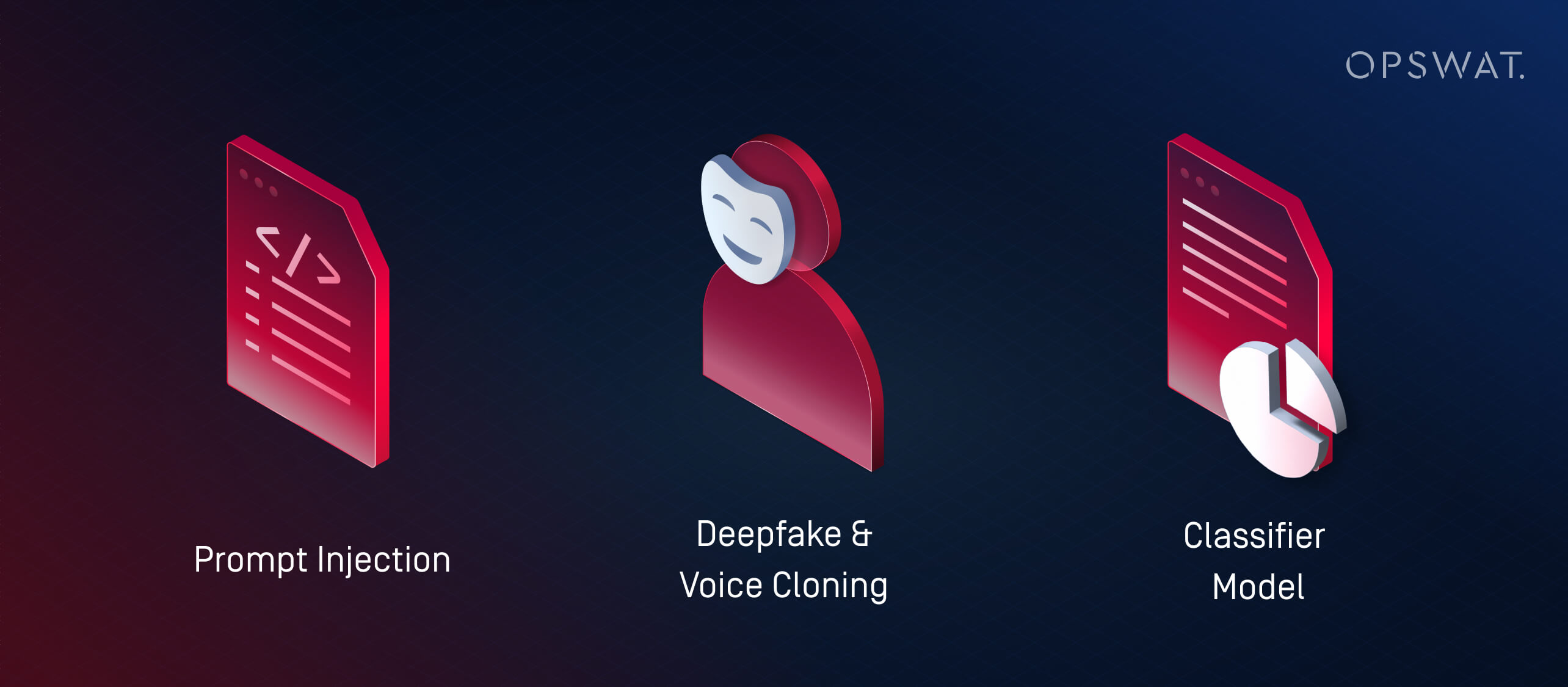

1. O que são ataques de injeção imediata?

A injeção de prompts é uma técnica em que os atacantes exploram vulnerabilidades nos LLM (modelos de linguagem de grande dimensão), alimentando-os com entradas especialmente concebidas para anular o comportamento pretendido. Estes ataques exploram a forma como os LLMs interpretam e dão prioridade às instruções, muitas vezes com pouco ou nenhum malware tradicional envolvido.

Em vez de utilizar a IA para lançar ataques externos, a injeção imediata transforma os próprios sistemas de IA de uma organização em agentes involuntários de compromisso. Se um LLM for incorporado em ferramentas como help desks, chatbots ou processadores de documentos sem as devidas salvaguardas, um atacante pode incorporar comandos ocultos que o modelo interpreta e actua. Isto pode resultar em:

- Fuga de dados privados ou restritos

- Execução de acções não intencionais (por exemplo, envio de e-mails, alteração de registos)

- Manipulação dos resultados para difundir desinformação ou desencadear acções subsequentes

Estes riscos aumentam nos sistemas em que vários modelos transmitem informações entre si. Por exemplo, uma mensagem maliciosa incorporada num documento pode influenciar um sintetizador de IA, que depois transmite informações incorrectas aos sistemas a jusante.

À medida que a IA se torna mais integrada nos fluxos de trabalho empresariais, os atacantes visam cada vez mais estes modelos para comprometer a confiança, extrair dados ou manipular decisões de dentro para fora.

2. O que são os ataques Deepfake e de clonagem de voz?

Os ataques Deepfake utilizam áudio ou vídeo gerados por IA para se fazerem passar por pessoas em tempo real. Em conjunto com tácticas de engenharia social, estas ferramentas estão a ser utilizadas para fraude, roubo de credenciais e acesso não autorizado ao sistema.

A clonagem de voz tornou-se especialmente perigosa. Com apenas alguns segundos de discurso gravado, os agentes de ameaças podem gerar áudio que imita o tom, o ritmo e a inflexão. Estas vozes clonadas são depois utilizadas para:

- Fazer-se passar por executivos ou gestores durante chamadas urgentes

- Enganar os empregados para que façam transferências bancárias ou redefinam a palavra-passe

- Contornar sistemas de autenticação vocal

Os deepfakes vão mais longe, gerando vídeos sintéticos. Os agentes de ameaças podem simular um CEO numa videochamada a pedir dados confidenciais - ou aparecer em clipes gravados "anunciando" alterações de políticas que espalham desinformação. O Ponemon Institute relatou um incidente em que os atacantes usaram mensagens geradas por IA fazendo-se passar por RH durante o período de inscrição de benefícios de uma empresa, o que levou ao roubo de credenciais.

À medida que as ferramentas de IA se tornam mais acessíveis, mesmo os pequenos agentes de ameaças podem gerar imitações de alta fidelidade. Estes ataques contornam os filtros de spam tradicionais ou as defesas dos pontos terminais, explorando a confiança.

3. O que são ataques a modelos de classificadores (Adversarial Machine Learning)?

Os ataques ao modelo de classificador manipulam as entradas ou o comportamento de um sistema de IA para forçar decisões incorrectas sem necessariamente escrever malware ou explorar código. Estas tácticas enquadram-se na categoria mais vasta de aprendizagem automática adversária.

Existem duas estratégias principais:

- Ataques de evasão: O atacante cria uma entrada que engana um classificador, levando-o a identificá-la incorretamente, como é o caso do malware que imita ficheiros inofensivos para contornar os motores antivírus

- Ataques de envenenamento: Um modelo é treinado ou afinado com dados deliberadamente distorcidos, alterando a sua capacidade de detetar ameaças

Os modelos supervisionados são muitas vezes "sobreajustados": aprendem padrões específicos a partir de dados de treino e falham ataques que se desviam ligeiramente. Os atacantes exploram este facto utilizando ferramentas como o WormGPT (um LLM de código aberto aperfeiçoado para tarefas ofensivas) para criar cargas úteis fora dos limites de deteção conhecidos.

Esta é a versão de aprendizagem automática de uma exploração de dia zero.

Hacking com IA vs. Hacking tradicional: Principais diferenças

Os hackers de IA utilizam a IA para automatizar, melhorar e escalar os ciberataques de IA. Em contraste, a pirataria tradicional requer frequentemente a criação manual de scripts, conhecimentos técnicos profundos e um investimento de tempo significativo. A diferença fundamental reside na velocidade, escalabilidade e acessibilidade: mesmo os atacantes novatos podem agora lançar ciberataques sofisticados com IA com algumas instruções e uma GPU de nível de consumidor.

Aspeto | Hacking de IA | Hacking tradicional |

|---|---|---|

Velocidade | Quase instantâneo com a automatização | Scripting manual mais lento |

Requisitos de competências | Baseado em prompts; baixa barreira à entrada, mas requer acesso ao modelo e afinação | Elevado; requer conhecimentos técnicos profundos |

Escalabilidade | Elevada - suporta ataques em várias fases a muitos alvos | Limitado pelo tempo e esforço humanos |

Adaptabilidade | Dinâmico - a IA ajusta as cargas úteis e a evasão em tempo real | Scripts estáticos ou semi-adaptáveis |

Vectores de ataque | LLMs, deepfakes, ataques a modelos classificadores, agentes autónomos | Malware, phishing, reconhecimento manual e exploits |

Advertências | Pode ser imprevisível; carece de intenção e de contexto sem supervisão humana | Controlo mais estratégico, mas mais lento e manual |

Utilização indevida da IA e aprendizagem automática adversária

Nem todas as ameaças à IA envolvem a geração de malware - algumas visam os próprios sistemas de IA. As tácticas de aprendizagem automática adversária, como a injeção imediata e o envenenamento de modelos, podem manipular classificadores, contornar a deteção ou corromper a tomada de decisões. À medida que a IA se torna central para os fluxos de trabalho de segurança, esses ataques destacam a necessidade urgente de testes robustos e supervisão humana.

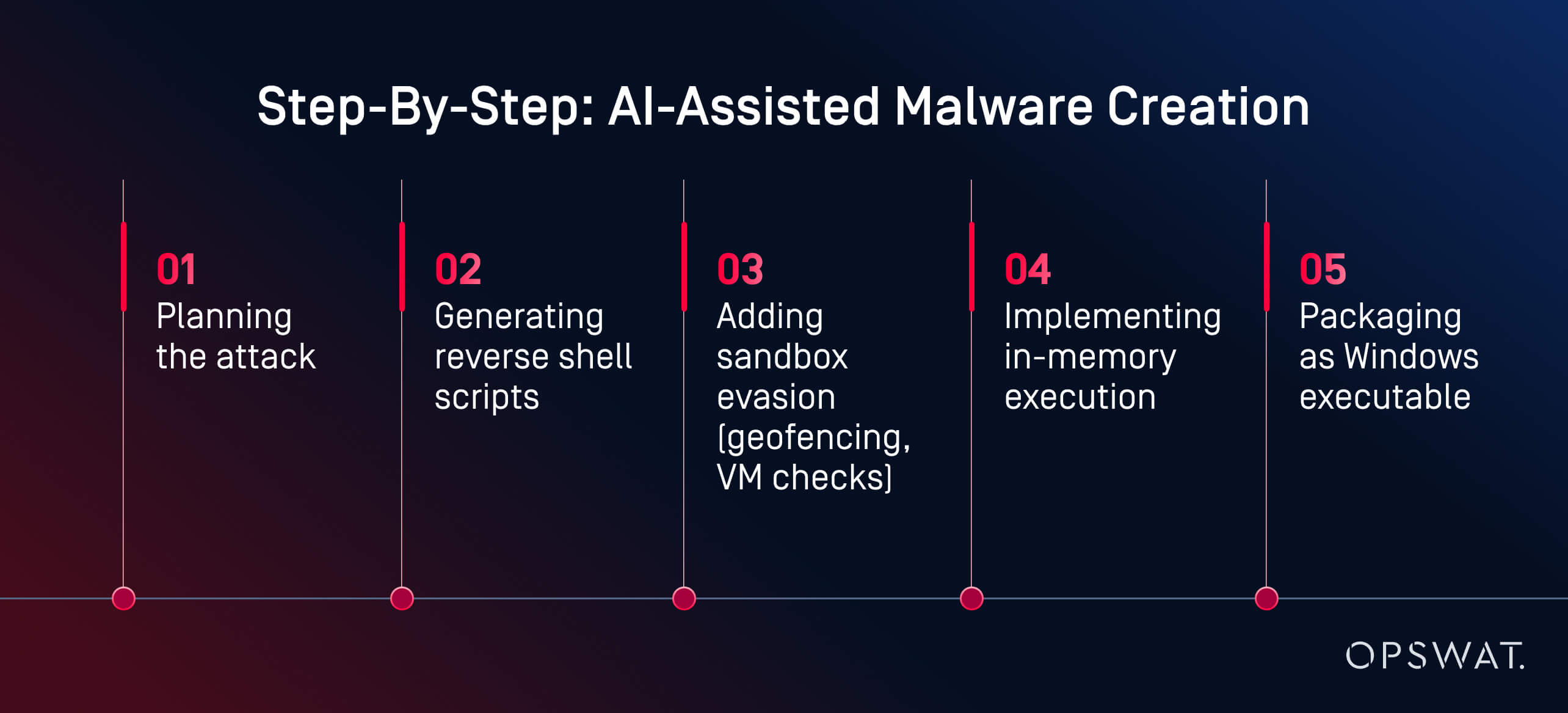

Como a IA pode ser utilizada indevidamente para desenvolver malware: Uma análise de peritos OPSWAT

O que antes exigia competências avançadas, agora requer instruções e alguns cliques.

Numa experiência em direto, o especialista em cibersegurançaOPSWAT , Martin Kallas, demonstrou como as ferramentas de IA podem ser utilizadas para criar malware evasivo de forma rápida, barata e sem competências avançadas. Utilizando o HackerGPT, Martin criou uma cadeia completa de malware em menos de duas horas. O modelo guiou-o em todas as fases:

"A IA guiou-me em todas as fases: planeamento, ofuscação, evasão e execução", explicou Martin. O resultado foi "... uma carga útil gerada por IA que evitou a deteção por 60 dos 63 mecanismos antivírus no VirusTotal". A análise comportamental e o sandboxing também não conseguiram identificá-lo como malicioso.

Não se tratava de um Estado-nação. Não foi um hacker de chapéu preto. Foi um analista motivado que utilizou ferramentas publicamente disponíveis numa GPU de consumo. O principal facilitador? Modelos de IA sem restrições e hospedados localmente. Com mais de um milhão de modelos de código aberto disponíveis em plataformas como a Hugging Face, os atacantes podem escolher entre uma vasta biblioteca, ajustá-los para fins maliciosos e executá-los sem supervisão. Ao contrário dos serviços baseados na nuvem, os LLM locais podem ser reprogramados para ignorar as protecções e executar tarefas ofensivas.

"Isto é o que um amador motivado pode construir. Imaginem o que um Estado-nação pode fazer", alertou Martin. O seu exemplo mostra como a má utilização da IA pode transformar o cibercrime de uma profissão especializada num fluxo de trabalho acessível e assistido por IA. Atualmente, a criação de malware já não é um obstáculo. A deteção tem de evoluir mais rapidamente do que as ferramentas que os atacantes têm agora na ponta dos dedos.

Como se defender contra ciberataques com recurso a IA

Precisamos de uma defesa em camadas - não apenas de uma deteção mais inteligente.

A defesa dos sistemas contra ciberataques alimentados por IA requer uma estratégia em várias camadas que combine a automação com a perceção humana e a prevenção com a deteção. As principais soluções de cibersegurança baseadas em IA, como a plataforma avançada de prevenção de ameaças da OPSWAT, integram a prevenção e a deteção. Veja o vídeo para saber mais.

Testes de segurança com IA e Red Teaming

Muitas organizações estão a recorrer a equipas vermelhas assistidas por IA para testar as suas defesas contra a utilização indevida de LLM, injeção imediata e evasão de classificadores. Essas simulações ajudam a descobrir vulnerabilidades em sistemas integrados à IA antes que os invasores o façam.

As equipas vermelhas utilizam avisos adversários, phishing sintético e cargas úteis geradas por IA para avaliar se os sistemas são resilientes ou exploráveis. Os testes de segurança com IA também incluem:

- Modelos de fuzzing para riscos de injeção imediata

- Avaliar como os LLMs lidam com entradas manipuladas ou encadeadas

- Testar a robustez do classificador face ao comportamento evasivo

Os líderes de segurança também estão a começar a analisar os seus próprios LLMs para detetar fugas imediatas, alucinações ou acesso não intencional à lógica interna, o que é um passo crucial à medida que a IA generativa é incorporada em produtos e fluxos de trabalho.

Uma pilha de defesa mais inteligente: A abordagem da OPSWAT

Em vez de tentar "combater a IA com a IA" num ciclo reativo, Martin Kallas defende uma defesa proactiva em vários níveis. As soluções OPSWAT combinam tecnologias que visam o ciclo de vida completo da ameaça:

- Metascan™ Multiscanning: Executa ficheiros através de múltiplos motores antivírus para detetar ameaças não detectadas por sistemas com um único motor antivírus

- MetaDefender Sandbox™: Analisa o comportamento dos ficheiros em ambientes isolados, detectando mesmo cargas geradas por IA que escapam às regras estáticas

- Deep CDR™: Neutraliza as ameaças através da reconstrução de ficheiros em versões seguras, eliminando as explorações incorporadas

Esta pilha de segurança em camadas foi concebida para combater a natureza imprevisível do malware gerado por IA, incluindo ameaças polimórficas, cargas úteis na memória e iscas deepfake que contornam as ferramentas tradicionais. Uma vez que cada camada visa uma fase diferente da cadeia de ataque, basta uma para detetar ou neutralizar a ameaça e colapsar toda a operação antes que esta possa causar danos.

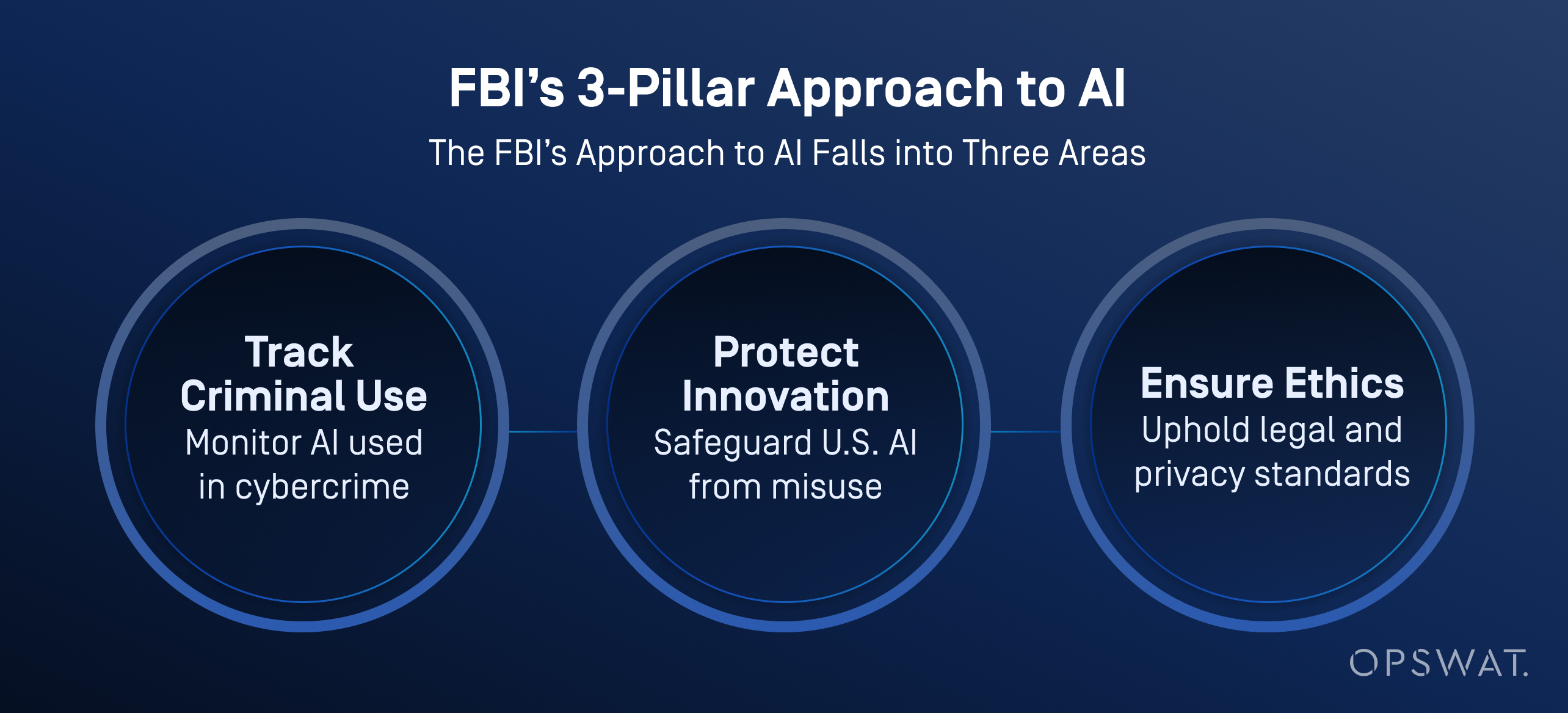

Casos de utilização no sector: Que IA é que o FBI utiliza?

O FBI e outras agências americanas estão a integrar cada vez mais a inteligência artificial nas suas operações de ciberdefesa, não só para fazer a triagem e dar prioridade às ameaças, mas também para melhorar a análise de dados, a análise de vídeo e o reconhecimento de voz.

De acordo com o FBI, a IA ajuda a processar grandes volumes de dados para gerar pistas de investigação, incluindo o reconhecimento de veículos, a identificação de idiomas e a conversão de voz em texto. É importante salientar que o FBI impõe uma supervisão humana rigorosa: todos os resultados gerados pela IA têm de ser verificados por investigadores formados antes de serem tomadas quaisquer medidas.

A IA não substitui a tomada de decisões por seres humanos. O FBI salienta que um ser humano é sempre responsável pelos resultados da investigação e que a IA deve ser utilizada de forma a respeitar a privacidade, as liberdades civis e as normas legais.

As organizações estão preparadas?

Apesar do aumento das ameaças impulsionadas pela IA, apenas 37% dos profissionais de segurança afirmam que se sentem preparados para travar um ciberataque impulsionado pela IA, tal como se afirma no Relatório sobre o Estado da Cibersegurança da IA da Ponemon. Muitos ainda dependem de planos de gestão de riscos cibernéticos desatualizados e de estratégias de deteção reativas.

O caminho a seguir requer 4 passos essenciais:

- Adoção mais rápida de ferramentas de defesa sensíveis à IA

- Formação contínua de equipas vermelhas e testes de risco imediatos

- Utilização ativa de Multiscanning, CDR e sandboxing

- Formação de analistas SOC para trabalharem com ferramentas de investigação automatizadas

A IA alterou as regras. Não se trata de substituir os humanos, mas de lhes dar as ferramentas para ultrapassar os ataques que agora pensam por si próprios. Explore como a nossa plataforma ajuda a proteger ficheiros, dispositivos e fluxos de dados em ambientes de TI e OT.

Perguntas frequentes (FAQs)

O que é a pirataria informática?

A pirataria informática é a utilização de ferramentas como os modelos de linguagem de grande dimensão (LLM) para automatizar ou melhorar os ciberataques. Ajuda os atacantes a criar malware, lançar campanhas de phishing e contornar as defesas mais rápida e facilmente do que antes.

Como é que a IA é utilizada para a cibercriminalidade?

Os criminosos utilizam a IA para gerar malware, automatizar o phishing e acelerar as análises de vulnerabilidades. Algumas ferramentas, como as que são vendidas em fóruns da dark web, podem até orientar os atacantes através de cadeias de ataque completas.

Qual é a diferença entre a pirataria informática e a pirataria tradicional?

O hacking tradicional requer codificação prática, utilização de ferramentas e competências técnicas. A pirataria informática reduz esta barreira com modelos que geram cargas úteis, scripts e conteúdos de phishing a partir de simples instruções. Estas técnicas tornam os ataques mais rápidos, mais escaláveis e acessíveis a amadores.

Como é que a IA pode ser utilizada indevidamente para desenvolver malware?

A IA pode gerar malware polimórfico, reverse shells e cargas úteis invasivas de sandbox com poucos dados. Como demonstrado numa demonstração ao vivo OPSWAT , um utilizador não malicioso criou malware de dia zero em menos de duas horas utilizando modelos de IA de código aberto executados num PC de jogos.

Poderá a IA substituir os hackers?

Ainda não, mas pode lidar com muitas tarefas técnicas. Os piratas informáticos continuam a escolher alvos e objectivos, enquanto a IA escreve código, escapa à deteção e adapta os ataques. O verdadeiro risco são os atacantes humanos amplificados pela velocidade da IA.

O que é um hacker de IA?

Um hacker de IA é uma pessoa ou um sistema semi-autónomo que utiliza a IA para lançar ciberataques, automatizar malware ou executar campanhas de phishing em escala.

Que IA é que o FBI utiliza?

O FBI utiliza a IA para triagem de ameaças, análise forense, deteção de anomalias e processamento de provas digitais. Estas ferramentas ajudam a automatizar as investigações e a revelar casos de elevada prioridade, reduzindo simultaneamente a carga de trabalho dos analistas.

Qual é um exemplo de um ataque de IA?

Um caso real envolveu e-mails de phishing gerados por IA durante o período de inscrição de benefícios de uma empresa. Os atacantes fizeram-se passar por RH para roubar credenciais. Noutro caso, a IA ajudou a automatizar a seleção de alvos de ransomware, obrigando uma marca multinacional a encerrar as operações.

O que são ciberataques de IA?

Os ciberataques com IA são ameaças desenvolvidas ou executadas com a ajuda da inteligência artificial. Os exemplos incluem o phishing gerado por IA, as imitações de deepfake, a injeção imediata e a evasão de classificadores. Estes ataques contornam frequentemente as defesas tradicionais.

Como é que os hackers e os burlões utilizam a IA para atingir as pessoas?

Os piratas informáticos utilizam a IA para personalizar mensagens de correio eletrónico de phishing, clonar vozes para fraudes telefónicas e gerar vídeos deepfake para enganar os alvos. Estas tácticas exploram a confiança humana e tornam mesmo os utilizadores bem treinados vulneráveis a enganos realistas, criados por IA.

Como é que me posso defender contra ataques com IA?

Utilizar uma defesa em camadas: Multiscanning, sandboxing, CDR e red teaming liderado por humanos. Os ataques de IA são rápidos. Os defensores precisam de automação, contexto e velocidade para acompanhar.